|

Newlearnerの自留地 @NewlearnerChannel |

#macOS #AI #Photos

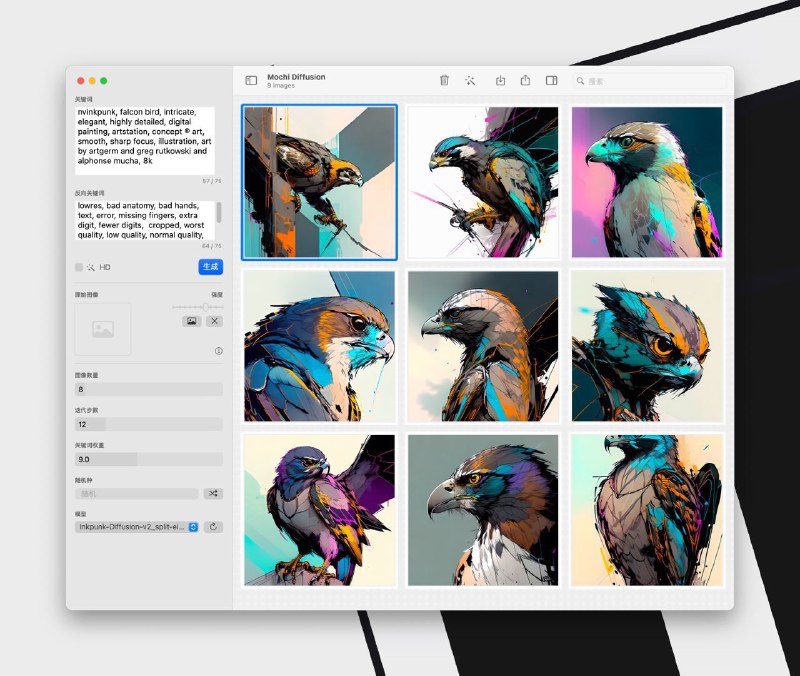

🏞 Mochi Diffusion:在 Mac 上原生运行 Stable Diffusion

👉 Features:

– 使用 macOS 原生框架 SwiftUI 开发

– 极致性能和极低内存占用 (使用神经网络引擎时 ~150MB)

– 在所有搭载 Apple 芯片的 Mac 上充分发挥神经网络引擎的优势

– 使用 RealESRGAN 放大生成的图像

– 自动保存 & 恢复图像

– 自定义 Stable Diffusion Core ML 模型

🍎 前不久 Apple 开源了原生 Core ML Stable Diffusion 框架,使得 Mac 能够原生运行 Stable Diffusion,生成图片速度更快。今天要介绍的 Mochi Diffusion 就是根据它开发的 GUI

💡 下载好之后,我们还需要下载训练好的模型才能使用。官方提供了一些 Models,它们之间的区别主要在于训练量和训练风格方向,我比较喜欢的模型是 Inkpunk 和 lofi-V2。用户需要通过 Git 方式将模型下载到本地,并解压放入 ~/Documents/MochiDiffusion/models

💻 加载好模型后输入关键词、反关键词,调整必须参数,即可开始生成图片。计算单元有两种:CPU 和神经网络引擎能很好地平衡性能和内存占用,CPU 和 GPU 在 M1 Max/Ultra 及后续型号上可能更快,但会占用更多内存

👀 在初次运行模型时, 神经网络引擎可能需要约2分钟编译缓存,后续运行速度会显著提高。尝试了 Inkpunk 模型后,无论是生成速度还是生成质量,都让我刮目相看

本文转自: https://t.me/NewlearnerChannel/10815

仅做个人收藏,版权归原作者所有